品牌介绍

查看更多

创立于1998年,由拉里·佩奇和谢尔盖·布林共同创建。Google拥有包括智能手机,搜索引擎,移动操作系统,广告服务等产品。Google的搜索引擎是其最出名的产品,被认为是全球最大的搜索引擎。

产品系列

查看更多

明星单品

查看更多

-

Google 谷歌 Pixel 5a 5G手机 6GB+128GB 黑色5549元起

Google 谷歌 Pixel 5a 5G手机 6GB+128GB 黑色5549元起 -

Google 谷歌 pixel 6 5G手机7529元起

Google 谷歌 pixel 6 5G手机7529元起 -

Google 谷歌 Pixel 4 4G手机1109元起

Google 谷歌 Pixel 4 4G手机1109元起 -

Google 谷歌 Pixel 5 4G手机5019元起

Google 谷歌 Pixel 5 4G手机5019元起 -

Google 谷歌 Pixel 4 XL 4G手机2600.21元起

Google 谷歌 Pixel 4 XL 4G手机2600.21元起 -

谷歌 Google Pixel 8/8Pro 谷歌八代手机 安卓原生系统 海外版 Pixel 8Pro 曜石黑 256GB6999元起

谷歌 Google Pixel 8/8Pro 谷歌八代手机 安卓原生系统 海外版 Pixel 8Pro 曜石黑 256GB6999元起 -

谷歌Pixel手机快充头30W充电器PD3.0快速充电器双typec快充线39.9元起

谷歌Pixel手机快充头30W充电器PD3.0快速充电器双typec快充线39.9元起 -

Google 谷歌 Pixel 7 曜石黑128G暂无报价

Google 谷歌 Pixel 7 曜石黑128G暂无报价

好价爆料

查看更多

品牌资讯

查看更多

-

资讯

谷歌 Pixel 8a 手机发布:Tensor 3处理器、主打 AI,售价 499 美元起昨晚除了苹果发布 iPad 新品,谷歌其实也发布了 Pixel 8a 但好似无人问津,今年依旧是在谷歌 I/O 大会之前...阅读全文

谷歌 Pixel 8a 手机发布:Tensor 3处理器、主打 AI,售价 499 美元起昨晚除了苹果发布 iPad 新品,谷歌其实也发布了 Pixel 8a 但好似无人问津,今年依旧是在谷歌 I/O 大会之前...阅读全文 -

资讯

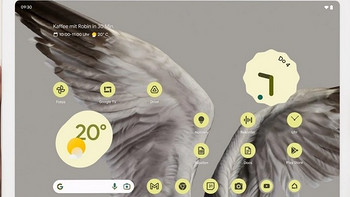

网传丨谷歌将发布新款 Pixel 平板,带手写笔和键盘据国外爆料者 MysteryLupin 消息,谷歌将在下个月的 I/O 开发者大会上发布新款 Pixel 平板,定位不高...阅读全文

网传丨谷歌将发布新款 Pixel 平板,带手写笔和键盘据国外爆料者 MysteryLupin 消息,谷歌将在下个月的 I/O 开发者大会上发布新款 Pixel 平板,定位不高...阅读全文 -

资讯

网传丨谷歌新款 Pixel Buds Pro 2 耳机收纳盒和电池曝光,容量增加、支持自适应降噪据外媒 91mobiles 消息,谷歌将要发布的 Pixel Buds Pro 2 无线耳机收纳充电盒现身。另外,收纳盒...阅读全文

网传丨谷歌新款 Pixel Buds Pro 2 耳机收纳盒和电池曝光,容量增加、支持自适应降噪据外媒 91mobiles 消息,谷歌将要发布的 Pixel Buds Pro 2 无线耳机收纳充电盒现身。另外,收纳盒...阅读全文

种草笔记

查看更多

-

亓纪的想法 篇一千零七十三:499美元起!谷歌Pixel 8a正式发布,主打AI超能力5月8日消息,谷歌发布了入门款机型Pixel 8a,这次的核心卖点是超惊艳、超强大和AI超能力。Pixel 8a搭载谷歌...阅读全文

亓纪的想法 篇一千零七十三:499美元起!谷歌Pixel 8a正式发布,主打AI超能力5月8日消息,谷歌发布了入门款机型Pixel 8a,这次的核心卖点是超惊艳、超强大和AI超能力。Pixel 8a搭载谷歌...阅读全文 -

高效远程管理,从选对软件开始!推荐这些热门远程管理软件远程管理软件主要用于远程控制和管理其他计算机或设备,无论是用于个人还是企业,它们都提供了方便快捷的方式来执行任务,如远程...阅读全文

高效远程管理,从选对软件开始!推荐这些热门远程管理软件远程管理软件主要用于远程控制和管理其他计算机或设备,无论是用于个人还是企业,它们都提供了方便快捷的方式来执行任务,如远程...阅读全文 -

🚨震惊!谷歌应用商店一年内屏蔽33.3万恶意开发者,力保用户安全🔒谷歌安全博客近期发布了,Play应用商店2023年度安全“战报”🔒2023年,谷歌再次加强了Play商店的安全防护措施,...阅读全文

🚨震惊!谷歌应用商店一年内屏蔽33.3万恶意开发者,力保用户安全🔒谷歌安全博客近期发布了,Play应用商店2023年度安全“战报”🔒2023年,谷歌再次加强了Play商店的安全防护措施,...阅读全文

众测

-

智慧大屏天猫精灵CC10,音箱平板安防All-in-One〇、前言前两年,我写过一篇小度音箱的众测,时过境迁,如今的智能音箱都已经开始带屏幕了。随着人工智能席卷全球,加上语音交互... 阅读全文犹豫94想买

智慧大屏天猫精灵CC10,音箱平板安防All-in-One〇、前言前两年,我写过一篇小度音箱的众测,时过境迁,如今的智能音箱都已经开始带屏幕了。随着人工智能席卷全球,加上语音交互... 阅读全文犹豫94想买 2020-05-31

2020-05-31

最新收录

-

谷歌(Google)Pixel 8A 智能手机 原生安卓系统 国际版 海外版 陶瓷白 128GB4949元起

谷歌(Google)Pixel 8A 智能手机 原生安卓系统 国际版 海外版 陶瓷白 128GB4949元起 -

谷歌Pixel手机快充头30W充电器PD3.0快速充电器双typec快充线39.9元起

谷歌Pixel手机快充头30W充电器PD3.0快速充电器双typec快充线39.9元起 -

谷歌/Google pixel 4代Pixel4XL移动联通三网4G原生谷歌手机 pixel4 屏幕有点印(非全新) 标配 64GB 中国大陆暂无报价

谷歌/Google pixel 4代Pixel4XL移动联通三网4G原生谷歌手机 pixel4 屏幕有点印(非全新) 标配 64GB 中国大陆暂无报价 -

Google 谷歌 Pixel 4代手机三网4G原生态安卓Pixel5 Pixel 4A996.02元起

Google 谷歌 Pixel 4代手机三网4G原生态安卓Pixel5 Pixel 4A996.02元起 -

Google 谷歌 Pixel 4a/Pixel 4A/Pixel 4a5G三网谷歌5G手机 pixel 4a屏有印 标配 128GB暂无报价

Google 谷歌 Pixel 4a/Pixel 4A/Pixel 4a5G三网谷歌5G手机 pixel 4a屏有印 标配 128GB暂无报价 -

谷歌 Google Pixel 8/8Pro 谷歌八代手机 安卓原生系统 海外版 Pixel 8Pro 曜石黑 256GB6999元起

谷歌 Google Pixel 8/8Pro 谷歌八代手机 安卓原生系统 海外版 Pixel 8Pro 曜石黑 256GB6999元起 -

Google谷歌 Pixel7a 原生安卓系统国际版拍照最新型号全机 北极蓝暂无报价

Google谷歌 Pixel7a 原生安卓系统国际版拍照最新型号全机 北极蓝暂无报价 -

谷歌(Google)pixel 7手机七代智能 6.4英寸OLED屏原生安卓系统自研芯片 Pixel 7a 碳灰色-128GB2339元起

谷歌(Google)pixel 7手机七代智能 6.4英寸OLED屏原生安卓系统自研芯片 Pixel 7a 碳灰色-128GB2339元起

谷歌 Google Pixel 8/8Pro 谷歌八代手机 安卓原生系统 海外版 Pixel 8Pro 曜石黑 256GB

6999元起